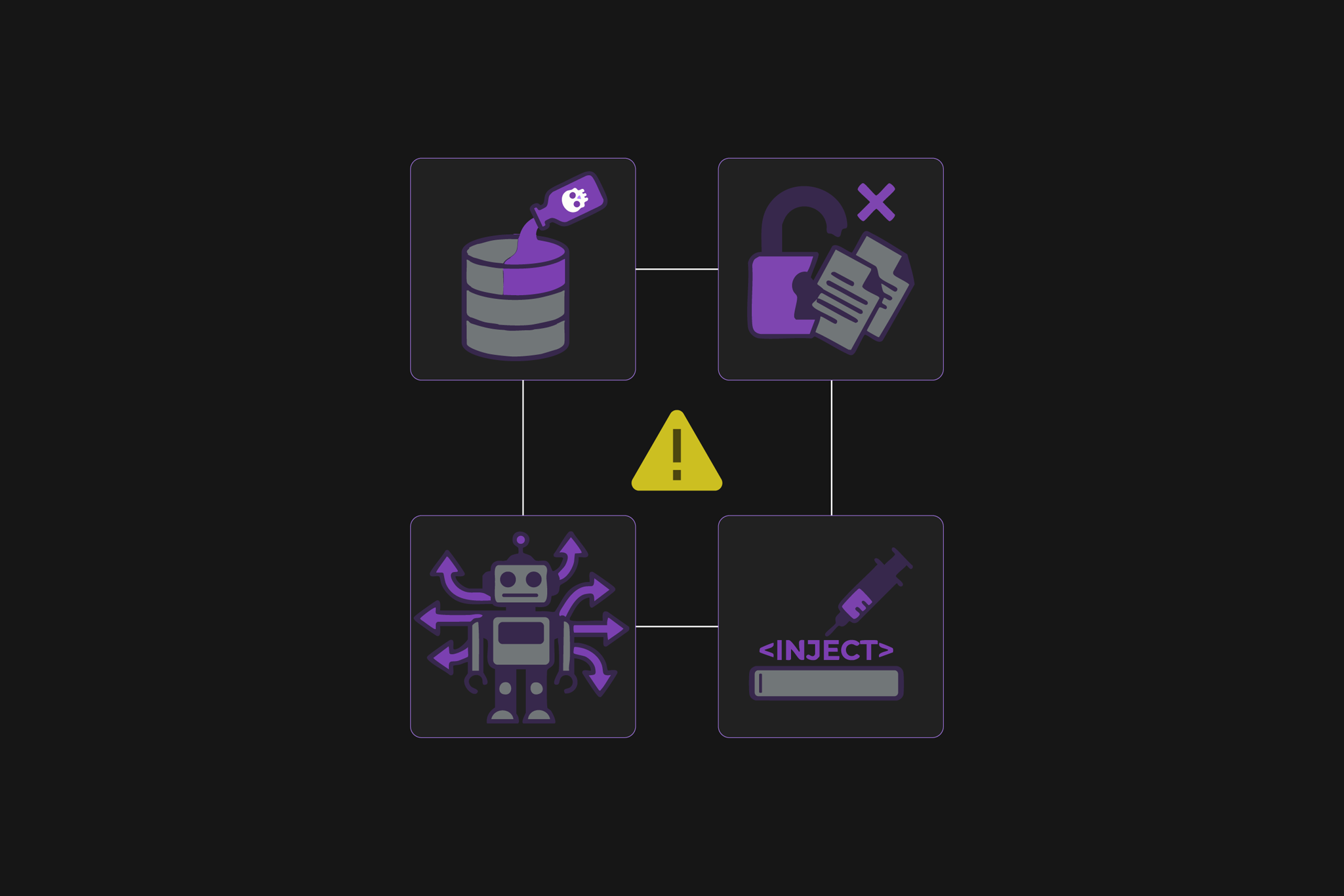

O avanço dos modelos de linguagem e agentes autônomos traz eficiência, mas também abre caminhos para ataques sofisticados que exploram desde falhas de projeto até comportamentos imprevisíveis dos modelos. A seguir, um panorama dos riscos mais relevantes e por que devem estar no radar de qualquer área de segurança.

Injeção de prompt

A manipulação de entradas continua sendo um dos vetores mais perigosos. Um prompt malicioso é capaz de desviar o comportamento de um modelo, revelar dados internos ou acionar funções que deveriam estar restritas. A ameaça se amplifica quando sistemas consomem dados externos que podem conter instruções ocultas. A mitigação exige validação rigorosa, contextos protegidos e filtros semânticos antes de permitir que o modelo gere ações sensíveis.

Vazamento de informações sensíveis

Modelos podem expor acidentalmente trechos de dados privados aprendidos durante treinamento, além de permitir que um invasor extraia informações por meio de prompts bem construídos. Ambientes RAG mal configurados também podem retornar documentos restritos. A defesa envolve sanitização de dados, controle de acesso estrito, técnicas de privacidade diferencial e monitoramento contínuo de saídas.

Vulnerabilidades na cadeia de suprimentos de IA

Modelos pré-treinados, bibliotecas e plugins compõem uma cadeia complexa e suscetível a adulterações. Um pacote malicioso ou um modelo comprometido pode afetar todo o ambiente. Ataques já exploraram dependências contaminadas e versões falsificadas de modelos populares. A prevenção passa por auditoria profunda, SBOM de modelos e dados, assinatura digital e testes de robustez antes da adoção de componentes externos.

Envenenamento de dados e modelos

Manipular o conjunto de treinamento pode inserir viés, backdoors ou instruções ocultas que alteram a lógica do modelo. Isso leva a respostas erradas ou comportamentos nocivos. A detecção depende de rastreamento de origem de dados, validação contínua e campanhas de adversarial testing.

Tratamento inadequado da saída

Quando respostas de LLM são usadas diretamente por sistemas downstream, surge o risco de execução de código malicioso. Um modelo pode gerar comandos, SQL ou scripts que, se não filtrados, criam brechas como XSS, RCE e SSRF. A regra é simples: tratar o LLM como fonte não confiável e aplicar sanitização robusta antes de qualquer integração.

Agência excessiva de agentes de IA

Conceder permissões amplas a agentes autônomos pode levar a ações destrutivas. Plugins com funções desnecessárias ou permissões elevadas criam pontos de abuso, especialmente quando combinados com falhas de prompt injection. Limitar escopo, exigir confirmações humanas e auditar extensões são práticas essenciais.

Fragilidades em embeddings e vetores

Bases vetoriais podem ser usadas para inferir dados sensíveis ou manipular resultados por meio de documentos adulterados. Consultas específicas permitem sondar regiões sensíveis da base. A mitigação inclui particionamento por acesso, criptografia, limpeza de documentos e monitoramento de anomalias.

Desinformação e confiança excessiva

LLMs podem produzir respostas falsas com aparente autoridade. Confiar cegamente nessas saídas impacta decisões críticas e pode introduzir vulnerabilidades em fluxos de trabalho. A solução envolve validação independente, revisão humana, cross checking e mecanismos de consistência.

Consumo descontrolado de recursos

Requisições volumétricas ou prompts que demandam operações pesadas podem causar interrupções e custos inesperados. Também há risco de ataques econômicos que exploram billing de APIs. Limites de taxa, validação de tamanho de entrada e monitoramento de uso são medidas fundamentais.

O papel de frameworks como OWASP LLM

Padrões como o OWASP Top 10 LLM e o LLM Security Verification Standard fornecem diretrizes maduras para identificar lacunas, estruturar avaliações de risco, revisar arquitetura e fortalecer pipelines de IA. Integrar esses frameworks aos processos de segurança aumenta a capacidade de identificar fraquezas antes que se tornem incidentes.

Conclusão

A adoção de IA não exige apenas novas ferramentas. Exige novas práticas de segurança e governança que entendam o modelo como parte do perímetro digital. Com mitigações adequadas e padrões consolidados, é possível extrair valor da IA com segurança, reduzindo riscos que tendem a crescer nos próximos anos.

Este conteúdo foi útil para você? Compartilhe em suas redes sociais: